AIアライメントネットワーク

設立記念シンポジウムレポート

【前編】

2024年9月9日にAIアライメントネットワーク(ALIGN:アライン)の設立記念シンポジウムが京橋エドグランartience本社内で開催され、オフラインで約80名、オンラインで約50名が出席した。ALIGNは「AIと人類の未来を先導する研究ネットワークの構築」を目指して2023年9月に設立され、半年の準備期間を経た後、2024年4月から研究およびコミュニティ形成、アウトリーチの活動を本格化させた。

同シンポジウムでは、2部構成で、研究者を中心に、企業やシンクタンク、政府関係者などをゲストに迎え、技術発展と安全性のバランスについて多様な視点から議論が行われた。とりわけ国内外のガバナンスやリスク管理、そして産官学の協力が注目され、生成AIやAGI(汎用人工知能)の進化とリスクに関わる課題についても共有された。

以下では報告書の前編として第1部について報告を行う。

プログラム

第1部:ALIGNの挑戦 ~非営利セクターから挑む分野創設~

14:30~14:55 講演:ALIGNの挑戦 髙橋恒一(ALIGN代表理事)

14:55~15:10 講演:プライバシーとAI 佐久間淳様(東京工業大学教授)

15:10~15:20 講演:AIを作る側からの視点 栗原聡様(人工知能学会会長)

15:20~15:40 特別講演「日本はどうAGIに備えるか(仮)」 平将明様(衆議院議員) 討論:小澤健祐様(AI Now)、山川宏(ALIGN理事)

2部:〈AIと人類の希望ある未来〉に向けた産官学連携

15:50~16:05 講演:次世代AIとAIリスク対策の研究動向 福島俊一様(科学技術振興機構フェロー)

16:05~16:20 講演:AIガバナンスの俯瞰 飯田正仁様(三菱総合研究所研究員)

16:20~16:25 録画登壇:AIセーフティの国内連携 村上明子様(AIセーフティ・インスティテュート所長)

16:25~16:55 パネル議論:〈AIと人類の希望ある未来〉のための産官学ネットワークに向けて

パネリスト:相澤彰子様(国立情報学研究所教授)、工藤郁子様(大阪大学特任准教授)、佐久間弘明様(東京大学/AIガバナンス協会) モデレーター:金井良太(ALIGN共同設立者)

16:55~17:00 閉会 髙橋恒一(ALIGN代表理事)

講演:ALIGNの挑戦 髙橋恒一(ALIGN代表理事)[ビデオ]

イベント第1部冒頭の講演では、ALIGN代表理事の高橋恒一氏が本シンポジウム全体の流れを説明した後、AIアライメントネットワーク(以降、ALIGN)設立の背景および主旨を紹介した。

一つ目の背景として、日本がAIガバナンスに関する国際的な議論を先導してきた歴史があることを挙げた。2015年に高橋氏は経済学者の井上智洋氏(駒澤大学経済学部准教授)らとともに「AI社会論研究会」を発足させ、それを母体に慶應義塾大学「AI社会共創ラボラトリ」を設立した。2017年にはALIGNのメンバーである高橋氏、山川氏、金井氏が専門家委員として参画し、総務省で「AI研究開発ガイドライン」を提唱。それがOECDやPartnership on AIなどの国際的なガイドラインに多大な影響を与えてきた。

2022年以降に生成AIの急速な普及が進んで以降は政府の動きもより活発になり、2023年の広島AIプロセスが立ち上がり、2024年には世界で3つ目のAIセーフティ・インスティテュートが発足するなど国の機関も設立された。

二つ目の背景としては、有害コンテンツやバイアス、プライバシー、情報環境の汚染など今日のAIがもたらす身近なリスクに関する議論が進められてきた一方で、より壊滅的なリスクを潜在的に持つ、自律兵器やAIを活用したバイオテロ、またはAIそのものの制御の不可能性についての議論を進める必要性が挙げられた。

三つ目の背景として、以上に述べた直近あるいは潜在的なリスクを踏まえて、産業界をはじめ、各国政府の関連機関、2023年3月に強力なAIの開発を6か月間停止することを求める署名を提出したFuture of Life Institute(生命の未来研究所)やCenter for AI Safety、ケンブリッジ大学のCenter for the Study of Existential Riskなど、AIが社会に対して壊滅的な損害を与えるリスクについて議論をする非営利の独立的な機関が発足し、議論を主導している。このように、AIの長期的なリスクに関する議論では、第三セクターである非営利団体が重要な役割を果たすと思われる。

以上の背景を踏まえ、長期的なリスクと短期的な課題に取り組む日本発の非営利の独立系組織としてALIGNが設立された。

ALIGNは3つの活動領域を構想している。まず1つ目は研究および研究の支援。2つ目はさまざまなステークホルダーと研究者、実務家をつなぐネットワークの形成。3つ目は、新たな社会の構築を促すための提言をふくむアウトリーチの活動である。

短期的な目標(高橋氏の定義では約18カ月)としては、国内外のステークホルダーのハブとなり、AIセーフティに関する議論を研究コミュニティや政策立案の場、あるいは日常といったさまざまな場面で普及させることである。

なお、AIアライメントは、それについて言及している論文によって異なる定義がされており、アカデミアにおいても定まった定義というものがまだ存在していない。例えば、ある論文では「AIシステムの目標や行動が開発者の意図や価値観に沿ったものであることを保証するプロセス」と定義され、別の論文では「社会の集団的な利益にかなうように行動する知的自律システムを構築するプロジェクト」と定義されている。

既存のAIアライメントの定義は、こちらの四象限のうち左上のマトリックス(a)が該当するが、高橋氏はALIGNで取り組む研究においては、もう少しスコープを拡大したいと語る。

AI技術は日進月歩で進化し続け社会実装が進められている。AIと人間との相互作用ならびにAI同士の相互作用も生じるため、AIアライメントも技術単体の問題として考えるのではなく、社会全体の課題として捉える必要があるだろう。従って(b)人間とAIの相互作用によって構成されるマルチエージェントシステムとしての社会の健全性確保、および(c)のような、より強力なAIが実現した社会におけるアライメント、さらにはそれら2つを重ね合わせた(d)人間とAIとASIの混成系としての社会における健全性確保について考える必要がある。ALIGNとしても積極的にそれらの領域での議論の推進に貢献していきたいと意欲を語り講演を終えた。

講演:プライバシーとAI 佐久間淳様(東京工業大学教授)

東京科学大学(旧・東京工業大学)教授の佐久間淳氏は、プライバシーの概念と規制の歴史を繙きながら、その保護の法的・技術的な側面を解説した。

19世紀におけるプライバシーは、「そっとしておいてもらう権利」と呼ばれており、政府等の要人を新聞などのメディアから守るために存在したが、報道の自由とのせめぎ合いが生じた。

20世紀になるとプライバシー保護の対象が要人に限らず一般市民にも拡張されるようになる。それらは自己情報コントロール権や積極的プライバシー権と呼ばれ、自分が持っている情報が適切に使われているかを考慮する権利だと考えられるようになり、19世紀のような単純な二項対立では解決できなくなった。

個人情報のデータ化やインターネットが普及した21世紀に入ると問題はさらに複雑になる。ユーザーはインターネットを介し無料でさまざまなサービスを利用できるのと引き換えに、検索やオンラインショッピングの履歴など多様かつ高頻度・高解像な個人情報をプラットフォーマーに渡すことになる。サービスを提供する巨大テック企業はそれらのビッグデータを解析し、レコメンドや広告によって巨額な利益を得ることで、もちつもたれつのデーターエコノミーの生態系が形成されている。

こうした状況下において、プライバシー保護と便益のバランスをいかにして取っていくのかは複雑かつ非常に難しい問題となるため、単純に法制度のみによって規制できるものではなく、計算機科学によって定式化や最適化することが必要である佐久間氏は語る。

こちらの図は、個人情報の活用とプライバシー保護技術の歴史をまとめた年表である。個人情報のデータ自体が経済に組み込まれるようになった契機はAmazonのレコメンドシステムが実装された2000年以降で、以降GoogleのAdSenseやFacebookのLookalikeなど、さまざまなプラットフォームで個人情報のデータが活用されるようになった。

一方で、アカデミアにおいてはプライバシー保護のための要素技術が古くからあった。暗号自体はさらに昔からあったが、こちらの図では最も古い技術として1978年のRSA暗号を挙げている。

しかし実際にこれらの技術が実装されるようになったのは、2006年に開発した統計的なプライバシー保護の技術である差分プライバシー(Dwork)が米国の国勢調査を行う統計局で使われ始めた2012年以降であり、トータルで12年のタイムラグがある。

こうしたタイムラグが生じた理由について佐久間氏は、セキュリティとプライバシーを比較しながら次のように解説した。まずセキュリティは、ある情報をAさんからBさんに受け渡す際に途中で、1ビットが誰かに漏れてないかを問題としているため、計算機科学の問題として比較的定義がしやすく研究も進んだ。

一方でプライバシーは、ある1ビット(性別かもしれないし、買った商品かもしれない)が外部に漏れた際に、何を知られたかによって当事者がどれくらい嫌なのか、というデータのセマンティックな要素が考慮されるため、数値的な定義が容易ではない。そのため計算機科学の領域ではセキュリティと比較して研究が遅れたという経緯がある。

その課題のブレークスルーとなったのが、差分プライバシーである。これは、ある人のデータの有無による出力の影響を定式化することで統計に基づくプライバシーの定義であり、これによりセマンティックな問題を回避しながらプライバシーを理論的に取り扱うフレームワークを構築できた。

差分プライバシーによってプライバシーの問題が扱えるようになった事例が上記のモデルである。ここからどのような情報が漏れていくのかがプライバシーの問題になるが、攻撃者がAIとインタラクションすることで、特定のデータが入力に含まれる時と含まれない時で、AIの挙動が変化するかを議論することで、情報が漏れたかを評価できる。

この時点で、AIとプライバシーの問題は一旦収束したかに見えた。しかし、生成AIの登場によって問題は再び発散することとなった。

なぜなら、入力が膨大なテキストコーパスであり、AIから出力されるアウトプットもまた長文の回答や画像、動画となると、特定のデータの有無を基準にしてプライバシーを議論することが困難になるからだ。よりハイコンテキストな判断が必要になるため、何をプライバシーと捉えればいいのかが再び発散してしまい、問題が振り出しに戻ってしまうこととなった。

プライバシーの問題をも内包するAIのアライメントの問題もまた、ミスアライメントを解決する技術を開発・実装することには多大な時間がかかると予想される。こうしたことを踏まえて佐久間氏は「研究者や企業それぞれががんばれば良い問題ではなく、特にテック企業とアカデミアの協調が必要である。そこではAIアライメントネットワークのように利害から離れた第三者の組織が非常に重要な役割を果たすと考えます」と述べて講演を締めくくった。

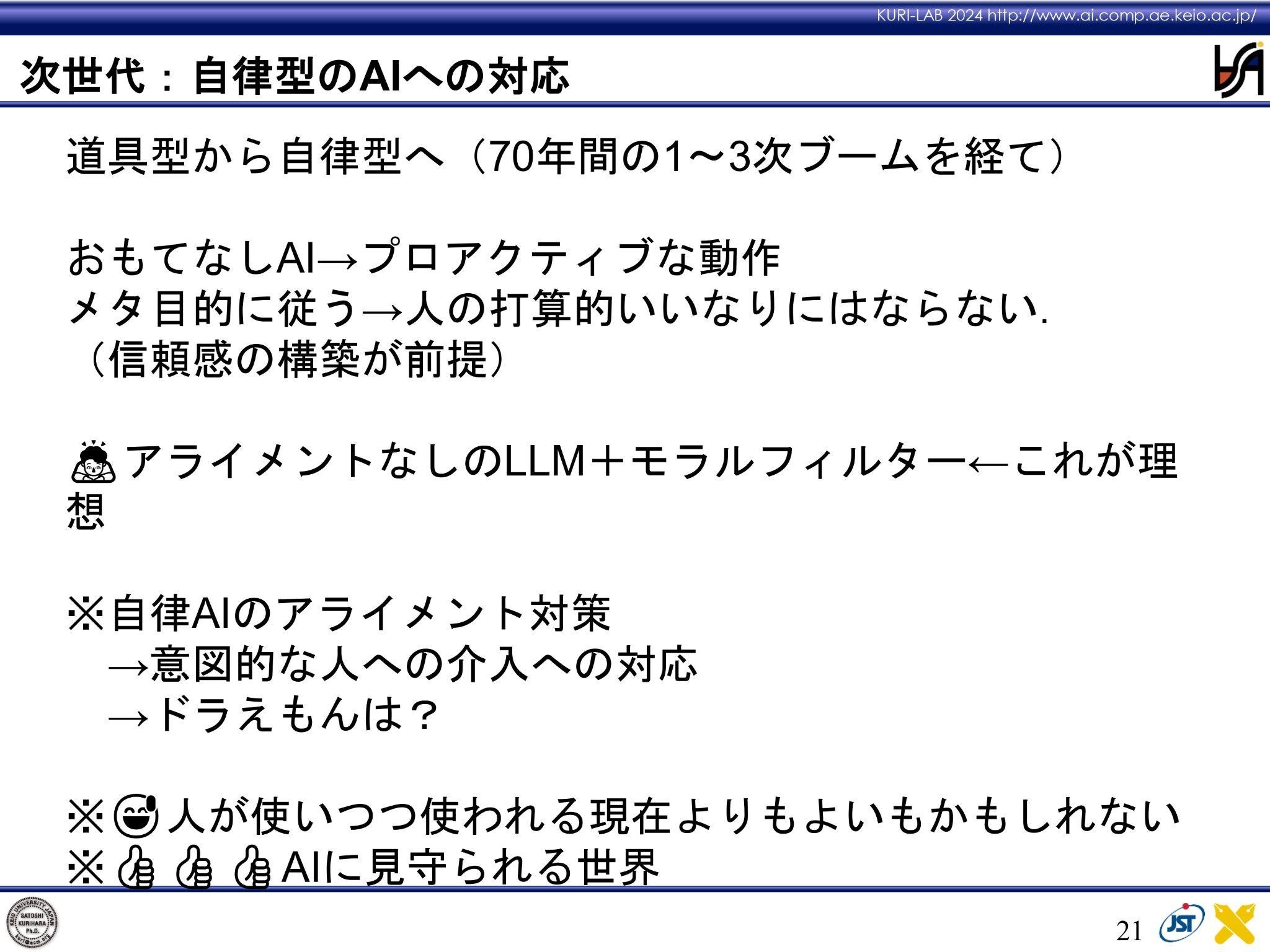

講演:AIを作る側からの視点 栗原聡様(人工知能学会会長)

人工知能学会会長の栗原聡氏は、人工知能を作る側の立場から講演を行った。研究・開発というアクセルを踏む一方でアライメントというブレーキを踏むことは、両者のバランスを取るという難しい判断が求められる。

まず栗原氏は、道具型のAIと自律型のAIを分けて議論する必要があると述べた。自律型のAGIはまだ実現できていないため、現時点での議論の対象となっているのは道具としてのAGIであり、そのようなAIは色々な機能を備えつつも、いつどの機能を使うかは人間が決定する必要がある。

AIアライメントとは、そうしたAIに対して「モラルに反することを言わない」というバイアスをかけることである。そうしたバイアスが創造的な活動を阻害する場合がある。栗原氏は手塚プロらとともに「TEZUKA2023(※)」に参加した際に、参加クリエイターに言及できない話題が多数あるChatGPTの使いづらさを指摘された。

※TEZUKA2023:『ブラックジャック』の“新作”を過去の手塚作品のデータとAIを活用して制作するプロジェクト

そうした経験を踏まえて栗原氏は、一旦アライメントというブレーキを排したLLMを開発し、それに対して個別にモラルフィルターをかけることが理想的なあり方だと述べた。なぜなら、モラルの基準は国や民族、地域の文化背景、あるいは時代によって変化するからである。

とはいえ結局のところALIGNや研究者が何を提唱しようと、OpenAIをふくめ世界中で高いシェアを誇るLLMを開発する企業やプラットフォームを運営する巨大テック企業がそれを採用しないことには、議論の結果が社会に及ぼす影響は極めて限られることになる。従ってLLMに依存しない形でのアライメントの仕方を模索することが重要となる。

LLMの進化が急速に進んでいく次の段階として予想される自律型の人工知能が実現すれば、人工知能がメタ目的に従って動く可能性がある。その際には人間と人工知能、あるいは人工知能同士の信頼関係のあり方も変化していくだろう。

道具型の信頼関係は制度によって規定可能だが、自律的な意志決定をするエージェントと人間の信頼関係は制度のみでは構築できないため、自律型の人工知能に対するアライメントを新たに定義する必要がある。ひとつの事例として栗原氏は、EUのAI研究者と『ドラえもん』を例に自律型の人工知能について議論をした際のエピソードを紹介した。

おそらく幼少期から『ドラえもん』に親しんできた日本人の多くは、人間社会に何となく馴染みながら、例えば「のび太くん、宿題しないとダメだよ」という形で生活に介入するドラえもんを、概ねポジティブな存在として受け止めるだろう。しかし、EUのAI研究者から見ればそれはAIによる人間社会への介入であり、脅威になりかねない存在と捉える傾向がある。従って、自律型のAIやロボットが実現した場合も、それらに対して強い規制をかけるかまったく取り入れない地域も出てくる可能性があるという。

こうした能動的なAIがマルチエージェント的な形で社会に実装された際に、人間と人工知能が信頼とともに協働することに対して最適な解を出すことは容易ではない。だからこそ、ALIGNのような組織がアカデミアもふくめたさまざまなステークホルダーと連携しながら議論の基盤を構築することには大きな意義があるだろう。

特別講演 平将明様(衆議院議員)

討論:小澤健祐様(AI Now)、山川宏(ALIGN理事)

第1部の最後には、衆議院議員の平将明氏による特別講演が行われた。平氏は、自由民主党の「AIの進化と実装に関するプロジェクトチーム(AIPT)」の座長としてAIに関する議論を積極的に推進してきた。2023年に行われたG7では「広島AIプロセス」を立ち上げ、AIに関するルールメイキングにおいて日本の存在感を国際的に示した。また、今年に入ってからは2024年4月10日にOpenAI社のサム・アルトマンCEOの訪日を設定し、岸田首相との会談を実現した。

日本政府として設定していた課題の一つは、ChatGPTのようなLLMを使用する際に言語が英語でないと出力されるものの精度が落ちるといった言語によるバイアスであり、日本人にとってのアクセシビリティにおける課題となっていた。しかし、前述のような働きかけを経て、言語によるバイアス問題は解決の方向に向かいつつある。

AIを使ったフェイク画像・動画やAIがテロなどに悪用されるリスク、進化したAIを人類がコントロールできなくなるリスクなど、課題は山積しているものの、AIに対する日本政府の基本方針は、世界で最もAIフレンドリーな日本を目指すことであると平氏は述べた。極めてリスクが高そうなAIに対して規制するハードローを策定する考えはあるものの、基本的にはガイドラインなどソフトローで運用する。AIの進歩は日進月歩であり、ハードローの策定と施行のタイムラグが生じるやり方では対応しきれなくなることが多い。従ってより柔軟に対応できるソフトローが望ましいということになる。

AIセーフティ・インスティテュート (AISI)は、AIの安全性を保障することを目的に国家が主導して運営する組織である。2023年11月に英国で行われたAI安全性サミットにおいて、英国と米国はそれぞれ独自のAISIを設立。日本は2024年2月14日に経済産業省の情報処理推進機構(IPA)の下部組織としてAISIを設立した。

すでに紛争地で実戦投入が始まっているAI兵器についても考える必要がある。AIが設定した標的への攻撃の最終的な可否の判断を人間が担うヒューマン・イン・ザ・ループを採用してはいるが、実際には設定した標的の大半に対して20秒に1回のペースで攻撃しているのが現実である。戦場をモニタリングして標的を設定するシステムが暴走するリスクもいまや荒唐無稽なフィクションとは言い切れなくなりつつある。新政権において強化するAIの司令塔を構築する際には、これらのような未来に起こり得るリスクも視野に入れつつ、政府は民間の知見も取り入れながら政策に反映させたいと語り講演を終えた。

Writer:高橋ミレイ